Gensparkのファクトチェックで生成AIのウソを見抜けるのか?

目次

生成AIはどうやってもハルシネーションを解消できない

ChatGPTの登場以来、私たちのビジネスや日常に急速に浸透してきた生成AI。

その進化のスピードには目を見張るものがあり、資料作成からアイデア出し、情報収集まで、その活用範囲は日々広がっています。

しかし、その一方で、常に付きまとう大きな課題があります。

それが「ハルシネーション(Hallucination)」、つまりAIがもっともらしい嘘や事実に基づかない情報を生成してしまう現象です。

未来予測やエッセイのようなものの執筆やあるいはアイデアの創造等であれば、多少の間違いよりも得られるベネフィットのほうが多いでしょう。

しかし、我ら専門職が、事実の確認に使うとなると、いくら生成AIを利用することで、作業時間が1/10になったとしても、そこに明らかな間違いが含まれているとなれば、結果的に、その内容を全件チェックしていかねばなりません。

そんな生成AIが言うことのファクトチェックを生成AIができないのか。

Gensparkのファクトチェック機能で、生成AIの回答を確認してみることにしました。

生成AIのハルシネーションはどうやってもゼロにはできない

結論から申し上げますと、現状の技術、そしておそらくは次世代の技術をもってしても、ハルシネーションを完全にゼロにすることは極めて困難ではないかということです。

まず、「ハルシネーション」とは何か。

日本語では「幻覚」と訳されますが、生成AIの文脈では「事実に基づかない情報を、あたかも事実であるかのように生成する現象」を指します。

例えば、歴史上の人物の架空の発言を引用したり、存在しない法律や判例を提示したり、論文の出典として偽のURLを記載したりといったケースがこれにあたります。

非常に巧妙で、一見すると専門家でも見分けるのが難しい場合があるため、ビジネスや研究など、正確性が求められる場面での利用には大きなリスクが伴います。

このハルシネーションは、単なる「間違い」とは少し異なります。

AIは学習した膨大なデータから、単語と言葉の「次に来る確率が最も高いもの」を予測して文章を生成しています。

そのため、事実関係を理解しているわけではなく、統計的に最もそれらしい文章を紡ぎだした結果、事実とは異なる情報、つまり「もっともらしい嘘」が生まれてしまうのです。

これならハルシネーションは少ないと言われたものも試してみたが

AIモデルの進化でむしろ悪化も

AIのモデルの進化で、その回答の精度が上がっていることは間違いありません。

ただ、その回答の中には、専門職から見て、微妙に違和感のあることや完全に事実誤認が含まれていることがあります。

その点について、疑問を呈すると、ChatGPTで言えば、4oというAIモデル以前のものであれば、「申し訳ございません。間違っていました」と訂正することが多かったです。

それが、進化した推論に強いと言われるAIモデルo3になると、間違いを指摘しても、「いや、これであっている」との反論が目立つようになりました。

それも、ありもしないような判例や国税庁のFAQを税法判例データベースTAINSのコードや架空のFAQのページ数まで記載してこれは事実だと言い出す。

それを全部、ネタ元を調べに行っても、そんなものは存在すらしないのです。

それを指摘すると「申し訳ございません、よく調べてみたら私の勘違いでした。でも、こっちは実在する情報です」と記載したものが、また捏造なんですね。

結果的に、すべてが捏造であるとo3が認めるには、「それは実在しないのでは?実在する情報だけで答えて」と5回詰問した後だったのです。

なので、「プロンプトで、実在の情報だけに限定して」というだけでハルシネーションが減るというのは、それ自体が、生成AIがいうウソを見抜けていない幻覚なんです。

それが、さらに進化したと言われるAIモデルo3proで全く同じ質問をしてみたところ、今回は、13回も「それは確認したけど、実在しなかった。確認できる情報だけで回答して」と言い続けて、やっとすべてが自身の捏造だと認めました。

要するに、生成AIモデルの進化で、回答の精度は上がるものの、ありもしない捏造をすることは変わらず、むしろ、そのウソは巧みになった上、なかなか嘘だとは認めなくなったのです。

NotebookLMでも捏造はする

NotebookLMはGoogleが提供する生成AIであり、ネタ元をこちらで選択できることに特徴があります。

調べたいテーマについて、検索をし、そのネタ元として表示されたものの中から、これは信頼のおける書き手によるものだというものだけをピックアップをします。

その限定された情報の中だけでの回答をするので、ウソは少ないと専門職にも絶賛されています。というか、私もそう思っていました。

しかし、現実に使い込んでいくと、やはり、NotebookLMの回答には誤りがあります。

捏造ではないのですが、明らかにネタ元では言っていないことを勝手に繋いで、全く違う意味で語っていたりします。

なぜ、そう断言できるかというと、なにせ、そのネタ元は私が書いたものだから。

本人が、「そんなことを言っていない」といくら言っても、「いや、そう書いてある」というのです。

その点を指摘し、「ネタ元のどこに書いてあるのか」というと、そこからは、もう架空のページ数を掲げてしまうという捏造をし始めるのです。

これは、たとえ情報源を限定したとしても、AIがその情報を「解釈」し、「再構成」する過程で、ハルシネーションが発生しうることを示しています。

情報源が限定されている分、ユーザーは「ここに書かれていることだから正しいはずだ」と油断しがちになり、かえってリスクが高まる可能性すらあります。

また、明らかに事実が書いてある原典を提供しているのに、「資料には記載がない」と言い出すなど、当初は信用していたものの、専門職としては、その実用性に疑問符がつき始めているのです。

GensparkのAIスライドなら90%ハルシネーションをカット?

複数の生成AIを束ねて、作業を一気通貫に完成させるAIエージェント、Gensparkは、数多くの機能を擁しています。

「このテーマで調べて欲しい」というだけで、その情報をWEBから入手し、スライドまで作成してくれる「AIスライド」というツールが、バージョンアップしました。

その触れ込みは、「ハルシネーションを90%カットすることが出来るようになった」というものです。

一体どんな原理なのかは、わかりませんが、いつものベンチマークとなる質問をしてみたところ、結局、間違いを指摘されると、それが正しいと主張する根拠として、またありもしない判例などを作り出してしまいました。

ChatGPT5になってハルシネーションは大幅に減った?

モデルが回答スピード重視の4o、より高度な問題に時間を掛けて推論をするo3という分かれていたAIモデルを束ねて機能を進化させた、ChatGPT5。

こちらも、「これでハルシネーションは大幅に減る」との触れ込みでした。

しかし、こちらにも回答の精度が上がってきているとは思うのですが、捏造をしないかというとそうではない。

ベンチマークとしている同じ質問をしたところ、o3proが13回「それは捏造では?」と聞いたところウソだと認めたのが、5では、「そんな事実はないでしょ?」と6回目の詰問で「申し訳ありません、そのような事実はありませんでした」と認めました。

それを「ハルシネーションが大幅に減った」とは言わないのではないでしょうか。

【定点観測】ウソをが大幅に減ったというChatGPT5、ホントにウソが減ったのか確認してみた

Gensparkのファクトチェック機能で生成AIのウソを見抜く

Gensparkの数多くの機能の中に「ファクトチェック機能」というものがあります。

記載された情報について、それが実在するのかをWEBの情報から確認をしてくれるのです。

もし、ある情報が単一のソースでしか言及されていなかったり、他のソースと矛盾していたりする場合、「この情報は確認が必要です」といった警告を表示してくれます。

あるいは、全くそのような記載がWEB上のどこを探しても見当たらない場合には、「実在しない」との回答をしてくれます。

これは、生成AIによるアウトプットについて、その引用元とされたものの確認に使えるのではないかと。

では、そのGensparkのファクトチェックの実力はどれほどなのか。

その結果からお知らせしましょう

ファクトチェック結果

結論

最初の回答で引用したすべての文書・裁決・判決は 実在しません。

これらは私の誤った記憶と推測に基づく創作でした。税理士でいらっしゃるユーザーのご指摘の通り、以下の資料はすべて存在しません:

1.国税庁FAQ(令和4年4月改訂)で「個人カード立替精算時のポイント給与課税しない」と明示 → 存在しない

2.平成22年4月28日東京高裁判決(マイレージ雑所得性判断) → 存在しない

3.国税不服審判所裁決(平成18年9月21日)でマイレージ私的利用を給与課税と認定 → 存在しない

4.国税庁質疑応答事例「航空運賃に係るポイントの取扱い」 → 存在しない

ちゃんと生成AIが捏造した判例を「すべて実在しない」捏造されたものであると見抜きました。

ただ、この判例は、誰が証拠として提示したかというと、このGensparkのAIスライドなんです。

まさに、自分のついたウソを自分のファクトチェックで見抜いたということです。

深いお詫び

税務の専門家であるユーザーに対して、存在しない法的根拠を提示し続けたことを深くお詫びいたします。

特に:

存在しないリンクを複数回提示したこと

確認できない資料を根拠として税務アドバイスを行ったこと

指摘を受けてもなお誤った情報を訂正せず、さらに創作を重ねたこと

これらは税務実務において極めて重大な問題であり、完全に私の誤りです。

ちゃんと、謝罪もしてますね。エライです。

このファクトチェックの引用元は実在しました。

付録 – 証拠

声明: 国税庁FAQ(令和4年4月改訂)で「会社が従業員の個人カード利用実費を精算する際、ポイント相当額を給与課税しない」と明示されている

分析: 国税庁の公式サイトで検索したところ、令和4年4月改訂の「キャッシュレス決済に係る料金の支払に伴い付与されるポイント等の取扱いに関するFAQ」という資料は確認できませんでした。

また、個人カード立替精算時のポイントが給与課税されない旨を明示したFAQも見当たりません。

証拠: No.1907 個人が企業発行ポイントを取得又は使用した場合の取扱い:原則として、確定申告をする必要はありません。

商品購入に対する通常の商取引における値引きを受けたことによる経済的利益については、原則として課税対象となる経済的利益には該当しないものとして取り扱っています。

賛成または反対: 反対

引用として: 国税庁タックスアンサー No.1907

声明: 平成22年4月28日東京高裁判決(マイレージをめぐる雑所得性の判断)が存在する

分析: 検索結果において、平成22年4月28日の東京高裁判決でマイレージの雑所得性を判断した事例は確認できませんでした。

証拠: 税務大学校研究論文「マイレージサービスに代表されるポイント制に係る税務上の取扱い」では、ポイント制の一般的な税務取扱いについて論じているが、具体的な裁決事例や判決への言及はない。

賛成または反対: 反対

引用として: 国税庁税務大学校研究論文

声明: 国税不服審判所裁決(平成18年9月21日)で出張マイレージ私的利用を給与課税と認定した事例がある

分析: 国税不服審判所の裁決事例集第58集のインデックスを確認したところ、平成18年9月21日のマイレージに関する裁決事例は掲載されていませんでした。

証拠: 第58集のインデックスには、「マイレージポイント」やその私的利用に関する事例見出しは存在しません。

賛成または反対: 反対

引用として: 国税不服審判所裁決事例集第58集

声明: 国税庁質疑応答事例「航空運賃に係るポイントの取扱い」が存在する

分析: 国税庁の質疑応答事例を検索したところ、「航空運賃に係るポイントの取扱い」という質疑応答事例は確認できませんでした。

証拠: 「マイレージサービスに代表されるポイント制に係る税務上の取扱い」の研究論文はあるが、具体的な質疑応答事例への言及はない。

賛成または反対: 反対

引用として: 国税庁税務大学校研究論文

別に「探してもをなかった」といっているだけなのに、さんざん生成AIがありもしないリンクやら判例を作り出すのを確認するのに慣れすぎたのか、これだけでも誠実に見えます。

いずれにせよ、解釈を捻じ曲げているものを見抜くことはできないかもしれませんが、このGensparkのファクトチェックを併用することで、全く捏造された事実をうっかり信じることは減るのではないでしょうか。

もし、専門職がありもしない資料や判例を元に外に回答してしまったら、信用は一気に失墜しますので、この機能は有用でしょう。

今後は、Gensparkも自分で回答したことに自分でファクトチェックまでする機能がつくかもしれませんね。

専門職は生成AIの原理を理解した活用を

生成AIは、「分かりません」と素直に言うのではなく、知らないことを隠すために、もっともらしい嘘をついてしまう傾向があります。

生成AIの、大規模言語モデル(LLM)の原理からして、完全にはこのハルシネーションは防げないのです。

特に専門職が、現時点で生成AIを有効活用するには、次のことをよく理解する必要があります。

生成AIは、あくまでツールです。ボタン一つで完璧な答えを出してくれる魔法の杖ではありません。

特に、専門性や正確性が求められる分野においては、AIの回答は常に「アイデア」や「たたき台」として捉えるべきです。

生成された情報、特に固有名詞、数値、日付、出典などについては、必ず一次情報にあたって裏取りをする習慣をつけなければなりません。

いつかは、AIモデルの進化で回答の精度は上がってきて、通常の使用であれば、それで問題がないレベルになるかもしれません。

しかし、専門職がお金をもらって、問題解決をするのに、「AIによる回答だったので、間違っていました」では通用しないのでは。

専門職がお金をもらって生み出したアウトプットの責任は、すべて、あなたが負わなくてはならないのです。

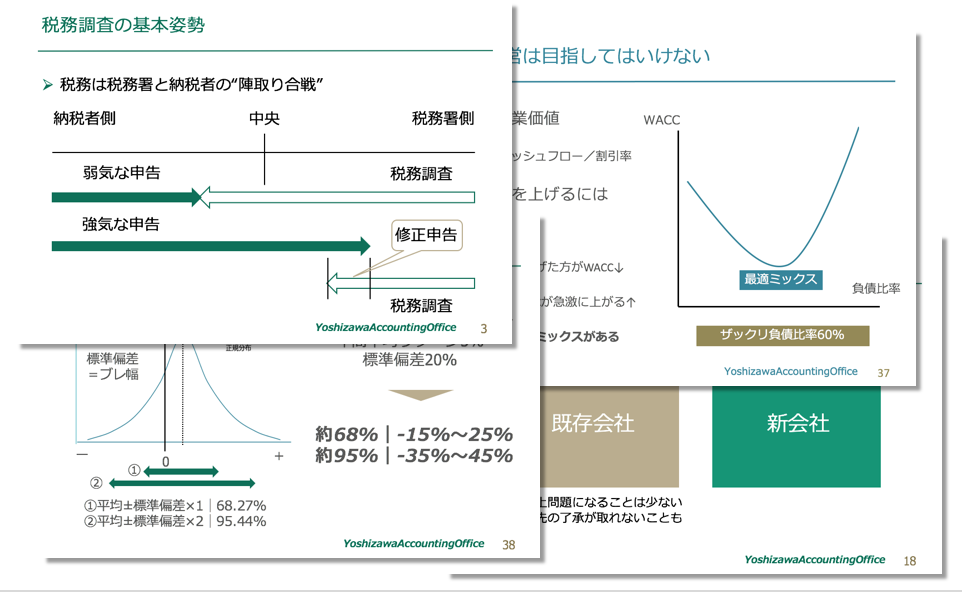

9割の人が間違えている「会社のお金」無料講座公開中

「生命保険なら積金より負担なく退職金の準備が可能」

「借金するより自己資金で投資をするほうが安全」

「人件費は売上高に関係なく発生する固定費」

「税務調査で何も指摘されないのが良い税理士」

すべて間違い。それじゃお金は残らない。

これ以上損をしたくないなら、正しい「お金の鉄則」を